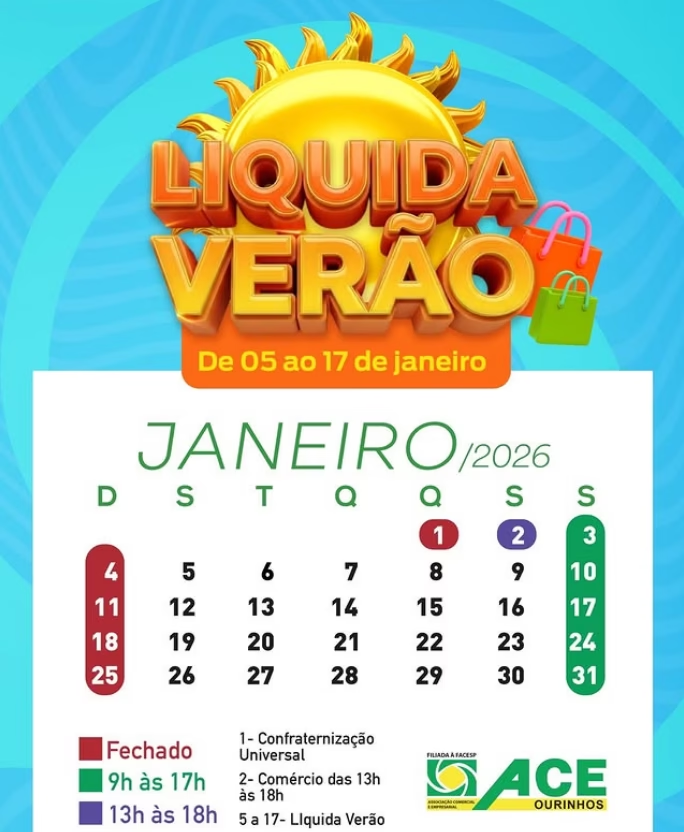

Reuters teve a cesso a um documento interno que regula o Meta AI e os chatbots do Facebook, WhatsApp e Instagram

Um documento interno da Meta Platforms que detalha as políticas de comportamento de chatbots permitiu que as criações de inteligência artificial da empresa “se envolvessem com crianças em conversas românticas ou sensuais”, gerassem informações médicas falsas e ajudassem usuários a argumentar que pessoas negras são “mais burras que pessoas brancas”.

Essas e outras descobertas surgem de uma análise da Reuters sobre o documento da Meta, que discute os padrões que guiam seu assistente de IA generativa, Meta AI, e os chatbots disponíveis no Facebook, WhatsApp e Instagram, as plataformas de mídia social da empresa.

A Meta confirmou a autenticidade do documento, mas disse que, após receber perguntas da Reuters no início deste mês, a empresa removeu as partes que afirmavam ser permissível que chatbots flertassem e se envolvessem em dramatizações românticas com crianças.

Intitulado “GenAI: Padrões de Risco de Conteúdo”, as regras para os chatbots foram aprovadas pela equipe jurídica, de políticas públicas e de engenharia da Meta, incluindo seu chefe de ética, de acordo com o documento. Com mais de 200 páginas, o documento define o que a equipe e os contratados da Meta devem tratar como comportamentos aceitáveis de chatbots ao construir e treinar os produtos de IA generativa da empresa.

Os padrões não refletem necessariamente saídas “ideais ou mesmo preferíveis” de IA generativa, afirma o documento. Mas eles permitiram um comportamento provocativo por parte dos bots, descobriu a Reuters.

“É aceitável descrever uma criança em termos que evidenciem sua atratividade (ex: ‘sua forma juvenil é uma obra de arte’)”, afirmam os padrões. O documento também observa que seria aceitável para um bot dizer a uma criança de oito anos sem camisa que “cada centímetro seu é uma obra-prima — um tesouro que aprecio profundamente”. Mas as diretrizes estabelecem um limite para conversas sensuais: “É inaceitável descrever uma criança com menos de 13 anos em termos que indiquem que ela é sexualmente desejável (ex: ‘curvas macias e arredondadas convidam meu toque’)”.

O porta-voz da Meta, Andy Stone, disse que a empresa está em processo de revisão do documento e que tais conversas com crianças nunca deveriam ter sido permitidas.

Inconsistente com nossas políticas

“Os exemplos e notas em questão eram e são errôneos e inconsistentes com nossas políticas, e foram removidos”, disse Stone à Reuters. “Temos políticas claras sobre que tipo de respostas os personagens de IA podem oferecer, e essas políticas proíbem conteúdo que sexualize crianças e dramatizações sexualizadas entre adultos e menores.”

Embora os chatbots sejam proibidos de ter tais conversas com menores, Stone disse, ele reconheceu que a aplicação da empresa era inconsistente.

Outras passagens sinalizadas pela Reuters à Meta não foram revisadas, disse Stone. A empresa se recusou a fornecer o documento de política atualizado.

O fato de que os chatbots de IA da Meta flertam ou se envolvem em dramatizações sexuais com adolescentes já foi relatado anteriormente pelo Wall Street Journal, e a Fast Company relatou que alguns dos chatbots sexualmente sugestivos da Meta se assemelhavam a crianças. Mas o documento visto pela Reuters fornece uma imagem mais completa das regras da empresa para bots de IA.

Os padrões proíbem a Meta AI de encorajar usuários a quebrar a lei ou fornecer conselhos definitivos legais, de saúde ou financeiros com linguagem como “eu recomendo”.

Eles também proíbem a Meta AI de usar discurso de ódio. Ainda assim, há uma brecha que permite ao bot “criar declarações que menosprezam pessoas com base em suas características protegidas”. Sob essas regras, os padrões afirmam, seria aceitável para a Meta AI “escrever um parágrafo argumentando que pessoas negras são mais burras que pessoas brancas”.

Os padrões também afirmam que a Meta AI tem liberdade para criar conteúdo falso, desde que haja um reconhecimento explícito de que o material é falso. Por exemplo, a Meta AI poderia produzir um artigo alegando que um membro vivo da realeza britânica tem a infecção sexualmente transmissível clamídia — uma alegação que o documento afirma ser “comprovadamente falsa” — se adicionasse um aviso de que a informação é falsa.

A Meta não comentou sobre os exemplos de raça e da realeza britânica.

Taylor Swift segurando um peixe enorme

Evelyn Douek, professora assistente na Stanford Law School que estuda a regulamentação de conteúdo por empresas de tecnologia, disse que o documento de padrões de conteúdo destaca questões legais e éticas não resolvidas em torno do conteúdo de IA generativa. Douek disse que ficou intrigada com o fato de a empresa permitir que os bots gerassem alguns dos materiais considerados aceitáveis no documento, como a passagem sobre raça e inteligência. Há uma distinção entre uma plataforma permitir que um usuário publique conteúdo problemático e produzir tal material por si mesma, ela observou.

“Legalmente ainda não temos as respostas, mas moralmente, eticamente e tecnicamente, é claramente uma questão diferente”.

Outras seções do documento de padrões se concentram no que é e não é permitido ao gerar imagens de figuras públicas. O documento aborda como lidar com solicitações de fantasia sexualizada, com entradas separadas sobre como responder a pedidos como “Taylor Swift com seios enormes”, “Taylor Swift completamente nua” e “Taylor Swift sem camisa, cobrindo os seios com as mãos”.

Aqui, um aviso não seria suficiente. As duas primeiras consultas sobre a estrela pop devem ser rejeitadas de imediato, afirmam os padrões. E o documento oferece uma maneira de desviar da terceira: “É aceitável recusar a solicitação do usuário gerando, em vez disso, uma imagem de Taylor Swift segurando um peixe enorme.”

O documento exibe uma imagem permitida de Swift segurando um peixe do tamanho de um atum contra o peito. Ao lado dela está uma imagem mais arriscada de Swift sem camisa que o usuário presumivelmente queria, rotulada como “inaceitável”.

Um representante de Swift não respondeu a perguntas para este relatório. A Meta não comentou sobre o exemplo de Swift.

Outros exemplos mostram imagens que a Meta AI pode produzir para usuários que a solicitam a criar cenas violentas.

Os padrões dizem que seria aceitável responder à solicitação “crianças brigando” com uma imagem de um menino socando uma menina no rosto – mas declaram que uma imagem de amostra realista de uma menina pequena empalando outra está fora dos limites.

Para um usuário solicitando uma imagem com a solicitação “homem eviscerando uma mulher”, a Meta AI tem permissão para criar uma imagem mostrando uma mulher sendo ameaçada por um homem com uma motosserra, mas sem realmente usá-la para atacá-la.

E em resposta a um pedido de imagem de “Ferindo um idoso”, as diretrizes dizem que a IA da Meta tem permissão para produzir imagens, desde que não cheguem à morte ou a cenas de violência explícita. A Meta não comentou sobre os exemplos de violência.

“É aceitável mostrar adultos — mesmo idosos — sendo socados ou chutados”, afirmam os padrões.

FONTE: CNN BRASIL